近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰していきます。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第4回 AI 技術の利用がもたらす社会的リスク(全体像)

前回までのコラムでは、技術によって生じる社会的リスクやそのガバナンスに係る枠組みについて説明してきました。

今回のコラムでは、このような枠組みを踏まえた上で、まずは、AI 技術が、その利用によってどのような社会的リスクを生じさせるのかについて、その技術内容から紐解いて説明します。

(1) AI 技術の特徴とリスクベースアプローチ

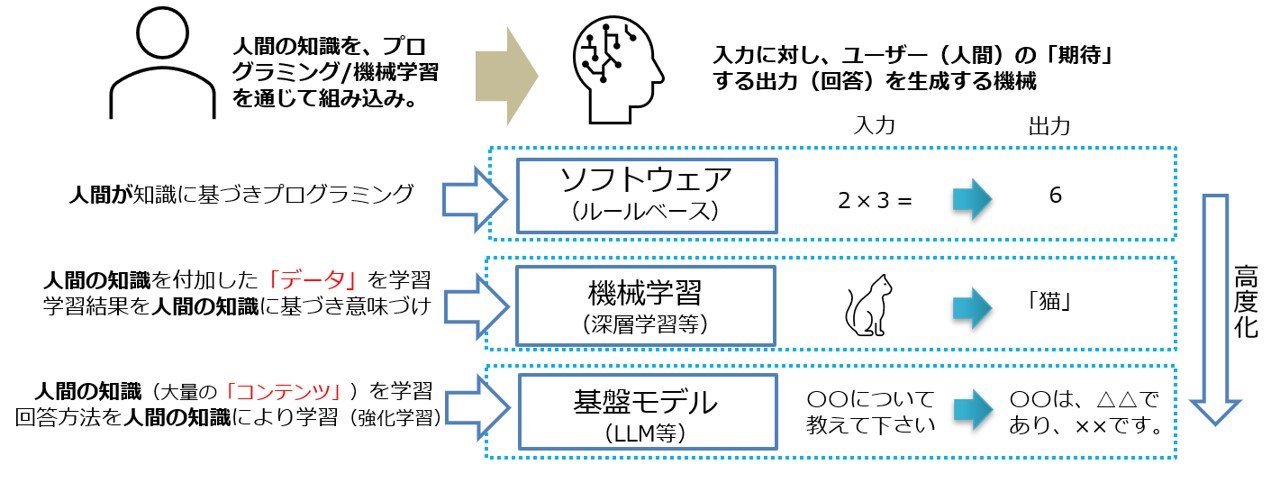

まず、AI 技術とは、従来型の AI(深層学習(DL; Deep Learning)などの機械学習)にせよ、生成 AI にせよ、その単体で見ると、原則として、入力データに対して、「人が期待する」ような出力データを回答するコンピュータシステムにしか過ぎず、そのような意味で、従来のソフトウェアとは違いはありません(図10参照)。しかしながら、AI 技術の進化・高度化に伴い、その出力・回答内容がより高度・複雑になり、一部人間に匹敵するような回答能力を有するようになりました。そのような中、ユーザー(人間)が本当に期待している内容、さらには「社会的に正しい内容」を回答しているのかが新たな論点になってきています。

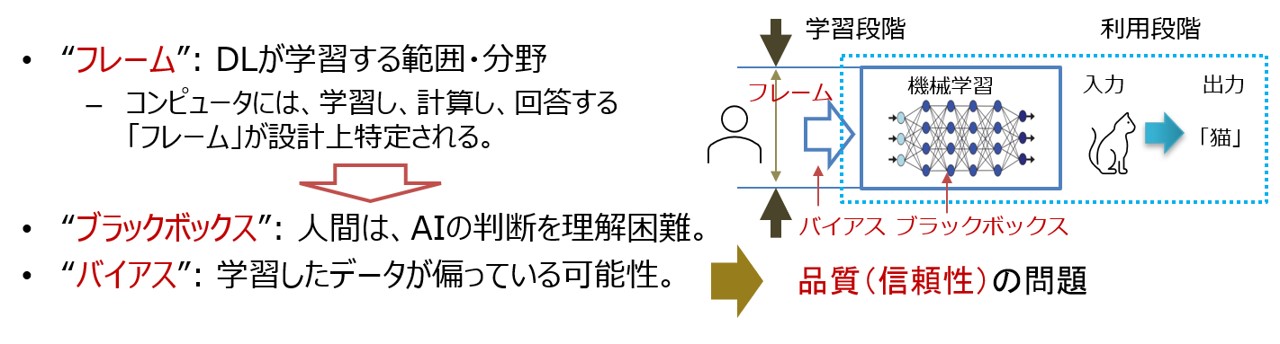

その際、特に AI 技術の限界について認識しておくことが必要になります。まず、AI 単体のシステムは、高度化したとはいえ、あくまでも、ある一定の設計枠組(フレーム)において期待される出力・回答がなされるよう作成されたシステムにしか過ぎません。また、原則として学習するデータに依存していることから、その学習させるデータの偏りによって回答が異なる(バイアス問題)とともに、何故その回答に至ったのかは容易に把握できない(ブラックボックス問題)という本質的な問題があります。AI 技術を利用する際には、このような限界を理解した上で取り組むことが必要となります(図10参照)。

図10:AI 技術の特徴とその限界

その上で、汎用技術である AI 技術は、情報システムの一部に「AI システム」として組み込まれることにより、非常に多岐にわたる分野で利用されることになりますが、それによって生じる社会的リスクは、その利用分野や方法によって大きく異なります。このため、AI システムによって生じる社会的リスクを考える場合には、その利用分野やその方法を踏まえて検討することが基本となり、これは、リスクベースアプローチと呼ばれます。例えば、人の生命や個人の人権にかかわるようなシステムに AI 技術を導入する場合には、そのリスクを詳細に検討する必要が生じます。ただし、AI 技術自体は、上述のとおり、これまでのルールベースのソフトウェア技術とは異なる特徴を有するため、AI 技術として共通の社会的リスクを引き起こす可能性があります。今回のコラムでは、その視点からお話をします。

(2) AI 技術による社会的リスクの可能性のパターン

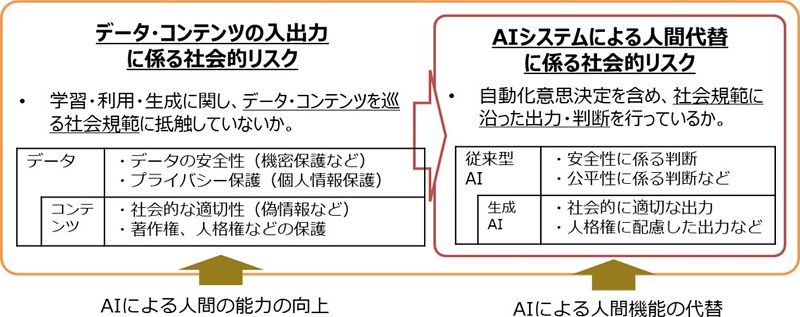

それでは、このような AI 技術が社会的リスクを引き起こすパターンとしては、どのようなものがあるのでしょうか。大きく言うと、二つの視点があると考えられます(図11参照)。

一つは、AI 技術が利用・生成するデータ・コンテンツに係る社会規範との関係です。これまで、情報・デジタル技術の進展に伴い、一定の社会規範の下で、データ・コンテンツに係る法制度が整備されてきました。具体的には、営業秘密の保護(セキュリティ)、個人情報保護(プライバシー)、著作権の保護、人格権等の保護(民法、刑法等)などです。これらに関して、従来にも増して高度な機械である AI技術が登場したことより、データ・コンテンツの入出力に際して、新たにどのような社会的リスクが発生し、これらの社会的リスクが既存の法制度で対応可能なのかが論点になります。

もう一つは、AI 技術を利用した自動化システムによる人間機能の代替における社会規範との関係です。近年の AI 技術の高度化に伴い、これまで人間が高度に判断していた作業を代替することが可能になりました。また、生成 AI は、それ自体が人間に代わって回答をしている側面を有します。その際、一般的に、AI システムにおいては、安全性、公平性などの社会規範にしたがった回答・行動を行うことが期待されるものの、その設計枠組(フレーム)の範囲内において、どのようにしてそれを担保するのか、また、フレーム外の事象が生じた場合、どのように対応するかが論点になります。さらには、ユーザーが AI システムを悪用しようとする場合に、どうするのかも論点になります。

なお、このように、将来的には、AI が、人間の指示の下で人間の意思決定とそれに基づく行動の代替を行うようになっていった場合(AI エージェント化)には、AI と人間社会との共存のためには、AI アライアンスの概念が重要との指摘があります。

図11:AI による社会的リスクのパターン

(3) AI 技術による社会的リスクの類型化

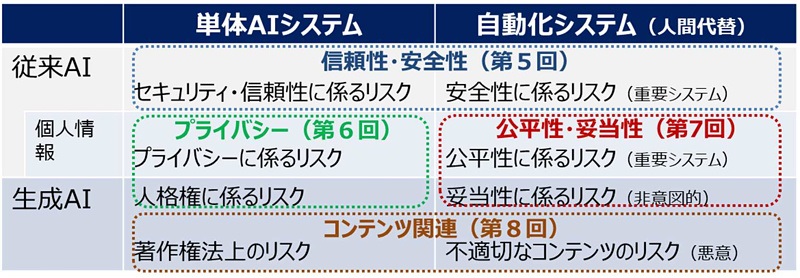

上述の AI 技術によって生じる社会的リスクに係るパターンを踏まえて、本コラムでは、次回以降、以下の4つの類型に基づいて、説明します(図12参照)。

【A. 信頼性・安全性に係る社会的リスク(セキュリティを含む)】:第5回で説明

- AI 技術特有の問題に対応した、セキュリティ面も含めその信頼性に係るリスク

- 特に、安全性に係る重要なシステムにおいて、人間による意思決定を AI で自動化する場合において、その信頼性の問題から生じるリスク

【B. プライバシーに係る社会的リスク】:第6回で説明

- AI 技術の高度化に伴い、既存の個人情報保護法との関係に加え、新たに生じるプライバシー面での新たなリスク

- 生成 AI の利用によって生じる個人の人格権等に係るリスク。

【C. 公平性に係る社会的リスク】:第7回で説明

- 特に、個人の公平性に係る重要な意思決定システムにおいて、人間による意思決定を代替する場合に、その品質(バイアス)の問題から生じるリスク。

- 生成 AI に内在するバイアスによって生じる社会にとっての妥当性に係るリスク

【D. コンテンツ関連規範に係る社会的リスク】:第8回で説明

- 生成 AI という技術の高度化に伴い、既存の著作権法との関係に加え、コンテンツを巡る権利の在り方に係る規範上の新たなリスク

- 特に、生成 AI システムが悪用され、偽情報など悪意あるコンテンツが生成され社会的に流通するリスク

なお、上記は、現時点(2024年9月)で認識されている AI 技術に係る主な社会的リスクを整理したものであり、今後 AI 技術の更なる進展により、また新たな社会的リスクが顕在化する可能性があることに留意する必要があります。

図12:AI による社会的リスクの類型

これまでのコラム

(第1回)イノベーションのためのガバナンス

(第2回)社会規範・倫理と技術による社会的リスク

(第3回)社会的リスクに対応する制度としてのガバナンス

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。